Por qué la mayoría de las IA interpretan mal las noticias

El problema no es la inteligencia, sino la perspectiva

La mayoría de las herramientas de IA que analizan o resumen noticias no se equivocan por falta de inteligencia. Fallan por los criterios y las perspectivas culturales sobre las que están construidas.

Los sistemas de IA no observan el mundo de forma directa. Aprenden de datos, reglas y decisiones tomadas por personas. Esas personas viven en algún lugar, trabajan dentro de ciertos sistemas y arrastran sus propias suposiciones. En la práctica, esto significa que muchos modelos reflejan una visión del mundo mayoritariamente estadounidense y de centroizquierda. Esa influencia no siempre es evidente, pero sí constante.

Esto importa porque Estados Unidos también tiene fuertes intereses políticos, económicos y corporativos. Lo que se enfatiza, suaviza u omite en los relatos públicos se replica después en las interpretaciones generadas por IA.

Analizar no es lo mismo que interpretar

Muchas herramientas resumen con precisión lo que dice un artículo. Otras van un paso más allá y clasifican la cobertura como de izquierda, derecha o neutral. Pueden resultar útiles, pero se quedan cortas a la hora de interpretar.

Muestran posiciones. No explican significado.

Lo que suele faltar es una respuesta a una pregunta más importante: ¿qué implica esto realmente para las personas y qué no se está diciendo? Ese vacío lo expliqué en Cómo analizar las noticias sin fingir que eres objetivo.

Ese hueco entre análisis e interpretación es donde la mayoría de las IA fallan. Reproducen la superficie de un artículo sin cuestionar su estructura, su escala o su intención.

El sesgo cultural se esconde en los criterios

El sesgo en la IA no solo proviene de los datos. También nace de los criterios utilizados.

Un ejemplo claro viene de fuera del periodismo. En los Países Bajos se emplearon sistemas de IA para detectar posibles fraudes en prestaciones sociales. Se trató como señales neutrales hechos como vivir con familia extensa o tener situaciones de vivienda irregulares. En la práctica, estos indicadores señalaron desproporcionadamente a personas con antecedentes migratorios.

El sistema no era malicioso. Era culturalmente estrecho.

Ese mismo mecanismo se aplica al análisis de noticias. Cuando los criterios están moldeados por una sola norma cultural, los comportamientos fuera de esa norma se etiquetan con facilidad como sospechosos, extremos o irrelevantes.

La escala es donde los relatos se rompen en silencio

Uno de los fallos más comunes en el análisis noticioso con IA es la escala.

Algunos temas reciben atención intensa aunque su presencia real sea limitada. Otros quedan infrarreportados pese a afectar a millones de personas.

El terrorismo es un ejemplo claro. En muchos países occidentales los atentados son raros, pero el miedo sigue alto. Los datos globales a largo plazo muestran altibajos en lugar de un aumento constante, y en varias regiones los incidentes han disminuido. Al mismo tiempo, la violencia en lugares como Somalia ha crecido con fuerza, mientras recibe poca cobertura sostenida.

Los sistemas entrenados con medios occidentales heredan este desequilibrio. Amplifican lo visible, no lo proporcional.

Una mirada global más amplia lo deja claro. Los conjuntos de datos de largo plazo muestran descensos en muchas zonas del mundo, mientras que los aumentos se concentran en unas pocas regiones, como Somalia. Mapas y líneas de tiempo hacen visible este desbalance de una forma que un solo titular nunca logrará.

El encuadre emocional distorsiona el juicio

Otro patrón recurrente es el encuadre emocional.

Las noticias suelen centrarse en víctimas con nombre, rostro e historia personal. Eso genera empatía, pero distorsiona la escala. Los grupos más grandes se convierten en estadísticas y el contexto se difumina.

Es un patrón clásico de deshumanización. Unas pocas vidas se vuelven vívidas, mientras que millones se reducen a números. Cuando eso ocurre, las respuestas extremas pueden parecer justificadas, aun cuando sean desproporcionadas.

La IA tiende a reproducir fielmente este encuadre. Refleja el énfasis emocional de la fuente sin cuestionar su efecto.

Las perspectivas ausentes casi nunca se señalan

Muchos artículos presentan afirmaciones fuertes sin incluir todas las voces relevantes. La persona acusada no aparece. Los representantes legales se citan de forma breve o ni siquiera se mencionan. Jueces o expertos independientes se incluyen únicamente al final, si aparecen.

Los resúmenes generados por IA siguen el mismo orden y énfasis. Si la información crucial está enterrada, permanece enterrada.

No es desinformación en sentido estricto. Es una incompletitud estructural.

Cuatro comprobaciones estructurales que importan

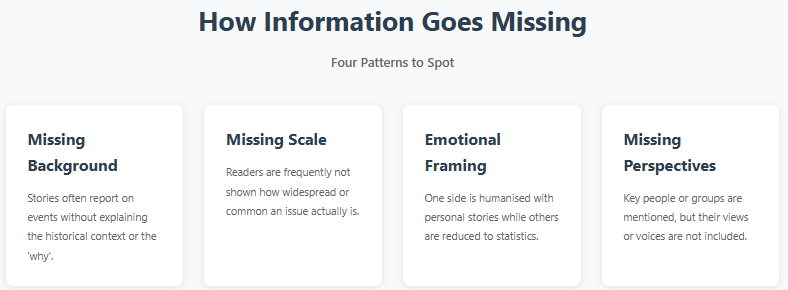

Al analizar noticias, cuatro elementos estructurales son clave:

Contexto. ¿El artículo explica antecedentes históricos o situacionales, o solo el hecho puntual?

Escala. ¿El fenómeno es generalizado, excepcional o estadísticamente marginal?

Encuadre emocional. ¿Se usan emociones para guiar la interpretación y se trata a los grupos de forma asimétrica?

Perspectivas ausentes. ¿Quién no habla y de quién no se muestran los intereses?

La mayoría de las herramientas de IA no evalúan explícitamente estos elementos. Se enfocan en coherencia, tono y frecuencia.

La velocidad crea confianza sin cuidado

Existe también un problema de incentivos. La gente espera respuestas rápidas. Los sistemas de IA son recompensados por la velocidad y la fluidez, no por la cautela.

Una respuesta segura en segundos se siente autoritaria, incluso si carece de profundidad. Pocas herramientas están diseñadas para ralentizar al lector o introducir una duda constructiva.

Lo que la IA debería hacer de forma distinta

La IA no necesita volverse neutral. La neutralidad no es alcanzable.

Lo que hace falta es honestidad estructural. Señales claras sobre la incertidumbre. Una separación explícita entre descripción e interpretación. Y marcos que expongan vacíos en lugar de rellenarlos automáticamente.

La colaboración entre culturas y fuentes de datos ayudaría. También una mayor transparencia sobre supuestos de entrenamiento y limitaciones.

Usar IA sin entregar el criterio propio

Esto no es un argumento contra el uso de IA para leer noticias. Es un argumento para usarla de otra manera.

La IA puede revelar patrones que los humanos pasan por alto. Puede procesar volúmenes que ninguna persona puede abarcar. Pero debe apoyar el juicio humano, no sustituirlo.

Esa es la propuesta de Impact News Lens. No te dice qué creer. Señala estructura, omisiones y encuadres para que tú decidas.

El objetivo no es desconfiar de todo. Es reconocer que la seguridad no es lo mismo que la exactitud.

Si la IA quiere ayudar a entender el mundo, debe empezar por admitir dónde no puede hacerlo.