Waarom de meeste AI het nieuws verkeerd leest

Het probleem is niet intelligentie, maar perspectief

De meeste AI-tools die nieuws analyseren of samenvatten, hebben het niet mis omdat ze dom zijn. Ze zitten ernaast vanwege de criteria en culturele perspectieven waarop ze zijn gebouwd.

AI-systemen kijken niet rechtstreeks naar de wereld. Ze leren van data, regels en beslissingen van mensen. Die mensen wonen ergens, werken binnen bepaalde systemen en dragen hun eigen aannames mee. In de praktijk betekent dit dat veel AI-modellen een overwegend Amerikaans, centrumlinks wereldbeeld weerspiegelen. Die invloed valt niet altijd op, maar is wel constant.

Dat is relevant omdat de Verenigde Staten sterke politieke, economische en zakelijke belangen hebben. Wat in publieke verhalen wordt benadrukt, afgezwakt of genegeerd, keert vaak terug in AI-gegenereerde interpretaties van het nieuws.

Analyse is iets anders dan interpretatie

Veel tools zijn goed in het samenvatten van wat een artikel zegt. Sommige gaan een stap verder en labelen berichtgeving als links, rechts of neutraal. Dat kan handig zijn, maar het blijft steken bij standpunten.

Ze tonen posities. Ze leggen geen betekenis uit.

Wat vaak ontbreekt, is antwoord op een belangrijkere vraag: wat betekent dit concreet voor mensen, en wat wordt níet gezegd? Over die kloof schreef ik eerder in Hoe je nieuws analyseert zonder te doen alsof je objectief bent.

Die kloof tussen analyse en interpretatie is precies waar de meeste AI het nieuws verkeerd leest. Ze reproduceert de oppervlakte van een artikel zonder structuur, schaal of intentie te onderzoeken.

Culturele bias zit verstopt in criteria

Bias in AI komt niet alleen uit data. Het zit ook in de gekozen criteria.

Een duidelijk voorbeeld komt van buiten de journalistiek. In Nederland werden AI-systemen ingezet om mogelijke uitkeringsfraude te signaleren. Criteria zoals wonen met familie of een onregelmatige woonsituatie golden als neutrale signalen. In de praktijk werden daarmee vooral mensen met een migratieachtergrond gemarkeerd.

Het systeem was niet kwaadaardig. Het was cultureel smal.

Hetzelfde mechanisme werkt bij nieuwsanalyses. Als criteria door één culturele norm worden gevormd, lijken gedragingen buiten die norm al snel verdacht, extreem of onbelangrijk.

Schaal is waar verhalen stilletjes breken

Een van de grootste missers in AI-gestuurde nieuwsanalyses is schaal.

Sommige onderwerpen krijgen enorm veel aandacht, zelfs wanneer ze in de werkelijkheid beperkt voorkomen. Andere topics blijven onderbelicht terwijl ze miljoenen mensen raken.

Terrorisme is een duidelijk voorbeeld. In veel Westerse landen zijn aanslagen zeldzaam, maar angst blijft hoog. Wereldwijde data over langere perioden laat schommelingen zien in plaats van een constante stijging, en in verschillende regio's is het aantal incidenten juist afgenomen. Tegelijkertijd is het geweld in landen als Somalië flink toegenomen, terwijl daar relatief weinig over wordt bericht.

AI-systemen die op Westerse media zijn getraind, erven deze disbalans. Ze versterken wat zichtbaar is, niet wat proportioneel is.

Een bredere mondiale blik maakt dat duidelijk. Langetermijndata laat zien dat terroristische incidenten in veel delen van de wereld afnemen, terwijl stijgingen vooral in enkele regio's voorkomen, zoals Somalië. Kaarten en tijdlijnen tonen die scheefgroei op manieren die één krantenkop nooit kan.

Emotionele framing vertroebelt oordeel

Een terugkerend patroon is emotionele framing.

Artikelen draaien vaak om individuele slachtoffers met namen, gezichten en persoonlijke verhalen. Dat wekt empathie, maar vertekent ook het gevoel voor schaal. Grotere groepen veranderen in statistieken en context verdwijnt naar de achtergrond.

Dit is een klassiek ontmenselijkingspatroon. Een paar levens krijgen kleur, miljoenen worden tot cijfers gereduceerd. Zodra dat gebeurt, voelen extreme reacties al snel gerechtvaardigd, ook als ze disproportioneel zijn.

AI neemt deze framing meestal één-op-één over. De emotionele nadruk van de bron wordt gespiegeld zonder de werking ervan te bevragen.

Ontbrekende perspectieven worden zelden gemarkeerd

Veel artikelen presenteren stellige claims zonder alle betrokken stemmen aan het woord te laten. De beschuldigde ontbreekt. Advocaten worden vluchtig of helemaal niet geciteerd. Rechters of onafhankelijke experts verschijnen pas aan het einde, als ze al voorkomen.

AI-samenvattingen volgen meestal dezelfde volgorde en nadruk. Als cruciale informatie is verstopt, blijft die ook verstopt.

Dat is geen desinformatie in strikte zin. Het is structurele incompleetheid.

Vier structurele checks die ertoe doen

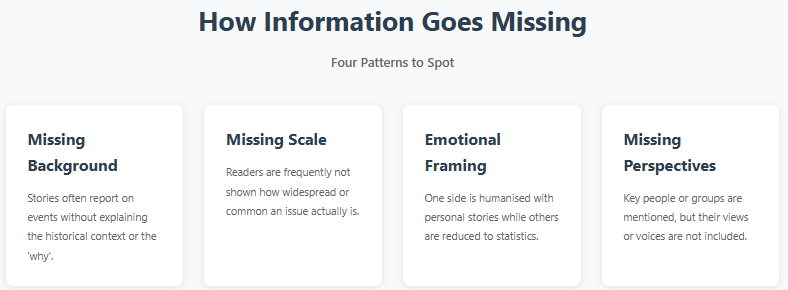

Bij nieuwsanalyses zijn vier structurele elementen cruciaal:

Achtergrond. Legt het artikel historische of situationele context uit, of alleen het incident?

Schaal. Is het onderwerp wijdverspreid, uitzonderlijk of statistisch marginaal?

Emotionele framing. Worden emoties ingezet om interpretatie te sturen, en worden groepen asymmetrisch behandeld?

Ontbrekende perspectieven. Wie spreekt er níet, en wiens belangen blijven buiten beeld?

De meeste AI-tools toetsen deze elementen niet expliciet. Ze focussen op samenhang, toon en frequentie.

Snelheid creëert zekerheid zonder zorg

Er speelt ook een prikkelprobleem. Mensen verwachten snel antwoord. AI-systemen worden beloond voor snelheid en soepel taalgebruik, niet voor terughoudendheid.

Een zelfverzekerd antwoord binnen enkele seconden voelt gezaghebbend, zelfs als het weinig diepgang heeft. Slechts weinig tools zijn gemaakt om lezers bewust te vertragen of constructieve twijfel in te bouwen.

Wat AI anders moet doen

AI hoeft niet neutraal te worden. Neutraliteit is niet haalbaar.

Wat nodig is, is structurele eerlijkheid. Heldere signalen over onzekerheid. Een expliciete scheiding tussen beschrijving en interpretatie. En raamwerken die hiaten zichtbaar maken in plaats van ze automatisch op te vullen.

Samenwerking over culturen en databronnen heen zou helpen. Net als meer openheid over trainingsaannames en beperkingen.

AI gebruiken zonder oordeelsvermogen op te geven

Dit is geen pleidooi om geen AI meer te gebruiken bij het lezen van nieuws. Het is een pleidooi om AI anders in te zetten.

AI kan patronen signaleren die mensen missen. Het kan volumes aan die geen enkel mens aankan. Maar het moet ons oordeel ondersteunen, niet vervangen.

Dat is de aanpak achter Impact News Lens. Deze tool vertelt je niet wat je moet geloven, maar markeert structuur, omissies en framing zodat je zelf kunt besluiten.

Het doel is niet om alles te wantrouwen. Het is om te erkennen dat zelfvertrouwen niet hetzelfde is als juistheid.

Als AI mensen wil helpen de wereld te begrijpen, moet het beginnen met erkennen waar het dat niet kan.