Warum die meisten KI-Systeme Nachrichten falsch einordnen

Das Problem ist nicht Intelligenz, sondern Perspektive

Die meisten KI-Tools, die Nachrichten analysieren oder zusammenfassen, liegen nicht falsch, weil sie unintelligent sind. Sie liegen daneben, weil sie auf bestimmten Kriterien und kulturellen Blickwinkeln aufbauen.

KI-Systeme beobachten die Welt nicht direkt. Sie lernen aus Daten, Regeln und Entscheidungen von Menschen. Diese Menschen leben irgendwo, arbeiten in bestimmten Strukturen und bringen ihre Annahmen mit. In der Praxis spiegelt sich das darin wider, dass viele Modelle ein überwiegend US-amerikanisches, mitte-links geprägtes Weltbild übernehmen. Diese Prägung ist nicht immer sichtbar, aber konstant.

Das ist relevant, weil die USA starke politische, wirtschaftliche und unternehmerische Interessen haben. Was in öffentlichen Narrativen betont, abgeschwächt oder ignoriert wird, taucht später in KI-generierten Deutungen wieder auf.

Analyse ist nicht gleich Interpretation

Viele Tools können sehr gut zusammenfassen, was ein Artikel sagt. Manche gehen weiter und versehen Beiträge mit Labels wie links, rechts oder neutral. Das kann nützlich sein, bleibt aber bei Positionen stehen.

Sie zeigen Haltungen. Sie erklären keine Bedeutung.

Was häufig fehlt, ist die Antwort auf eine wichtigere Frage: Was bedeutet das konkret für Menschen – und was wird gar nicht erwähnt? Genau über diese Lücke habe ich in Wie man Nachrichten analysiert, ohne Objektivität vorzutäuschen geschrieben.

Genau in diesem Abstand zwischen Analyse und Interpretation liegen die Fehlurteile vieler KI-Systeme. Sie reproduzieren die Oberfläche eines Artikels, ohne Struktur, Maßstab oder Absicht zu prüfen.

Kulturelle Verzerrung versteckt sich in Kriterien

Bias entsteht nicht nur durch Daten. Er steckt auch in den Kriterien.

Ein Beispiel kommt außerhalb des Journalismus vor. In den Niederlanden wurden KI-Systeme eingesetzt, um mögliche Sozialbetrugsfälle zu identifizieren. Als neutrale Hinweise galten Kriterien wie das Zusammenleben mit Großfamilien oder unregelmäßige Wohnsituationen. Tatsächlich trafen diese Marker überproportional Menschen mit Migrationshintergrund.

Das System war nicht böswillig. Es war kulturell eng.

Dasselbe Prinzip gilt für Nachrichtenanalysen. Wenn Kriterien nur von einer kulturellen Norm geprägt sind, werden Verhaltensweisen außerhalb dieser Norm schnell als verdächtig, extrem oder irrelevant eingestuft.

Maßstab ist der stille Bruch im Narrativ

Einer der häufigsten Fehler KI-gestützter Analysen ist der Umgang mit Maßstab.

Manche Themen bekommen enorme Aufmerksamkeit, obwohl sie in der Realität selten sind. Andere bleiben unterbelichtet, obwohl sie Millionen betreffen.

Terrorismus ist ein gutes Beispiel. In vielen westlichen Ländern sind Anschläge selten, doch die Angst bleibt hoch. Langfristige globale Daten zeigen Schwankungen statt eines stetigen Anstiegs, und in mehreren Regionen sind die Vorfälle zurückgegangen. Gleichzeitig hat die Gewalt in Ländern wie Somalia stark zugenommen, ohne dauerhaft im Fokus zu stehen.

KI-Systeme, die mit westlichen Medien trainiert wurden, übernehmen dieses Ungleichgewicht. Sie verstärken, was sichtbar ist – nicht, was verhältnismäßig ist.

Ein globalerer Blick macht das eindeutig. Langzeitdaten zeigen sinkende Zahlen in vielen Teilen der Welt, während Zunahmen auf wenige Regionen wie Somalia konzentriert sind. Weltkarten und Zeitachsen machen diese Schieflage sichtbar, wie es einzelne Schlagzeilen nie können.

Emotionale Rahmung verfälscht das Urteil

Ein weiteres Muster ist emotionale Rahmung.

Berichte stellen oft einzelne Opfer mit Namen, Gesicht und persönlicher Geschichte in den Mittelpunkt. Das schafft Empathie, verzerrt aber das Gefühl für Größe. Größere Gruppen werden zu Statistiken, Kontext rückt in den Hintergrund.

Das ist ein klassisches Entmenschlichungsmuster. Wenige Personen erscheinen lebendig, Millionen werden zu Zahlen. Dann wirken drastische Reaktionen schnell gerechtfertigt, selbst wenn sie unverhältnismäßig sind.

KI bildet dieses Framing meist unverändert ab. Sie spiegelt die emotionale Gewichtung der Quelle, ohne ihre Wirkung zu hinterfragen.

Fehlende Perspektiven bleiben unsichtbar

Viele Artikel formulieren starke Vorwürfe, ohne alle relevanten Stimmen einzubeziehen. Die beschuldigte Person fehlt. Anwälte kommen nur kurz oder gar nicht zu Wort. Richter oder unabhängige Expertinnen tauchen erst am Ende auf – wenn überhaupt.

KI-Zusammenfassungen übernehmen denselben Aufbau. Wenn wichtige Informationen versteckt sind, bleiben sie versteckt.

Das ist keine Desinformation im strengen Sinn. Es ist strukturelle Unvollständigkeit.

Vier strukturelle Prüfungen sind entscheidend

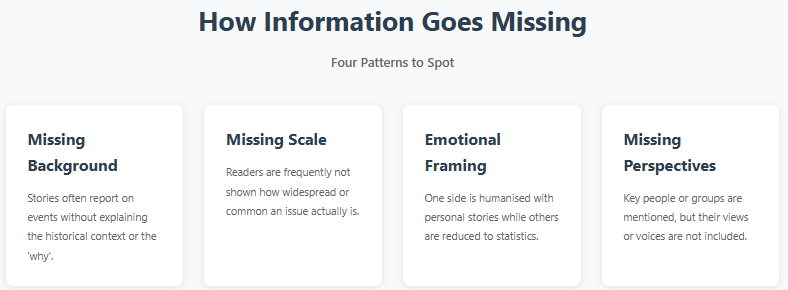

Für eine belastbare Analyse sind vier strukturelle Elemente besonders wichtig:

Hintergrund. Erklärt der Artikel historischen oder situativen Kontext – oder nur das Ereignis?

Maßstab. Ist das Thema weit verbreitet, außergewöhnlich oder statistisch marginal?

Emotionale Rahmung. Werden Emotionen eingesetzt, um die Deutung zu steuern, und behandelt der Text Gruppen asymmetrisch?

Fehlende Perspektiven. Wer kommt nicht zu Wort, wessen Interessen fehlen?

Die meisten KI-Tools prüfen diese Aspekte nicht explizit. Sie konzentrieren sich auf Kohärenz, Tonfall und Häufigkeiten.

Tempo erzeugt Sicherheit ohne Sorgfalt

Hinzu kommt ein Anreizproblem. Menschen erwarten schnelle Antworten. KI-Systeme werden für Tempo und sprachliche Eleganz belohnt, nicht für Zurückhaltung.

Eine souveräne Antwort nach wenigen Sekunden wirkt autoritativ, auch wenn sie wenig Tiefe hat. Nur wenige Werkzeuge sind darauf ausgelegt, Leserinnen zu bremsen oder konstruktive Zweifel zu fördern.

Was KI anders machen sollte

KI muss nicht neutral werden. Neutralität ist unerreichbar.

Notwendig ist strukturelle Ehrlichkeit. Klare Signale zu Unsicherheit. Eine bewusste Trennung zwischen Beschreibung und Interpretation. Und Rahmen, die Lücken sichtbar machen, statt sie automatisch zu füllen.

Zusammenarbeit über Kulturen und Datenquellen hinweg würde helfen. Ebenso mehr Transparenz über Trainingsannahmen und Grenzen.

KI nutzen, ohne das Urteilsvermögen abzugeben

Dies ist kein Plädoyer gegen KI beim Nachrichtenlesen. Es ist ein Plädoyer, sie anders einzusetzen.

KI kann Muster zeigen, die Menschen übersehen. Sie bewältigt Mengen, die niemand alleine lesen kann. Aber sie sollte Urteilsfähigkeit unterstützen, nicht ersetzen.

Das ist der Ansatz von Impact News Lens. Das Tool schreibt nicht vor, was du glauben sollst. Es macht Struktur, Auslassungen und Framing sichtbar, damit du selbst entscheiden kannst.

Ziel ist nicht, alles zu misstrauen. Ziel ist zu erkennen, dass Selbstsicherheit nicht mit Richtigkeit gleichzusetzen ist.

Wenn KI Menschen helfen will, die Welt zu verstehen, muss sie zunächst anerkennen, wo sie dazu nicht fähig ist.